نوشتار حاضر به بررسی فرآیندهای حفظ حریم خصوصی تفاضلی دادههای همبسته از طریق اضافه کردن نویز تمرکز دارد. به طور خاص در این مقاله به سه موضوع اصلی پرداخته شده است: تاثیرات همبستگی میان دادهها بر حریم خصوصی، تاثیرات دانشهای پیشین مهاجم بر حریم خصوصی و نهایتا یک الگوریتم پنهان سازی که قابلیت تعمیم به هرگونه مهاجمی با هر نوع دانش پیشین را داشته باشد.

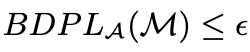

نتایج به دست آمده از تحلیلهای ارائه شده در این مقاله نشان میدهد که یک فرآیند حفظ حریم خصوصی تفاضلی میتواند در مواقعی که دادهها همبسته بوده و مهاجم نیز از دانش پیشینی پایینی برخوردار بوده، بسیار آسیبپذیر باشد. از این رو در این مقاله تعریف جدیدی مبتنی بر حریم خصوصی فرآیند از پیش معرفی شده Pufferfish با نام حریم خصوصی تفاضلی بیزین (Bayesian Differential Privacy) برای حل مشکل مذکور پیشنهاد شده است. تعریف پیشنهادی به شرح ذیل است:

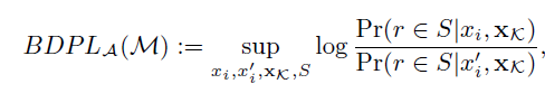

که در آن BDPL نشت حریم خصوصی تفاضلی بیزین است که براساس رابطه زیر نسبت به مهاجم A تعریف میشود:

در واقع براساس این تعریف، فرآیند و ساختاری میتواند حریم خصوصی تفاضلی بیزین را تامین کند که میزان نشت حریم خصوصی تفاضلی بیزین آن فرآیند مبتنی بر تعریف فوق، کمتر از ϵ باشد. ثابت شده است که حریم خصوصی تفاضلی بیزین نسخه سختگیرانهتری نسبت به حریم خصوصی تفاضلی اولیه معرفی شده است.

همچنین یک مدل همبستگی گاوسی برای تشریح و مدل کردن همبستگی میان دادههای با میزان همبستگی پیچیده طراحی و نهایتا با ارائه مفهوم توزیع پیشین هموار، تعمیم داده شده است. با نتایج به دست آمده از پیادهسازیهای ارائه شده در این مقاله میتوان نتیجه گرفت که مدل پیشنهادی قابلیت استفاده برای هر نوع مهاجمی با دانش پیشین نامعلوم را با حفظ سودمندی خواهد داشت.

Bin Yang, Issei Sato, and Hiroshi Nakagawa. 2015. Bayesian Differential Privacy on Correlated Data. In Proceedings of the 2015 ACM SIGMOD International Conference on Management of Data (SIGMOD ’15). Association for Computing Machinery, New York, NY, USA, 747–762. DOI:https://doi.org/10.1145/2723372.2747643